3.2.1 网络模型的选择

利用不同的模型进行分类,分别有VGG16、AlexNet、DenseNet、GoogleNet、Inception_v3、Resnet50和Squeezenet等网络模型,从中选出更优的网络模型来进行分类。下面是对这些网络结构模型的介绍。

AlexNet网络结构具有如下特点:① AlexNet在激活函数上选取了非线性非饱和的relu函数,在训练阶段梯度衰减快慢方面,relu函数比传统神经网络所选取的非线性饱和函数(如sigmoid函数,tanh函数)要快得多。② AlexNet在双GPU上运行,每个GPU负责一半网络的运算。③ 采用局部响应归一化(LRN)。对于非饱和函数relu来说,不需要对其输入进行标准化,但Alex等人发现,在relu层加入LRN,可形成某种形式的横向抑制,从而提高网络的泛化能力。④ 池化方式采用 overlapping pooling,即池化窗口的大小大于步长,使得每次池化都有重叠的部分。VGG16网络深,卷积核小,池化核小(与AlexNet的33池化核相比,VGG全部用的是22的池化层)全连接转卷积。

DenseNet网络结构具有如下特点:① 省参数。在ImageNet分类数据集上达到同样的准确率,DenseNet所需的参数量不到ResNet的一半。对于工业界而言,小模型可以显著地节省带宽,降低存储开销。② 省计算。达到与ResNet相当的精度,DenseNet所需的计算量也只有ResNet的一半左右。计算效率在深度学习实际应用中的需求非常强烈,从本次CVPR会上大家对模型压缩以及MobileNet和ShuffleNet这些工作的关注就可以看得出来。最近我们也在搭建更高效的DenseNet,初步结果表明DenseNet对于这类应用具有非常大的潜力,即使不用 Depth Separable Convolution 也能达到比现有方法更好的结果,预计在近期我们会公开相应的方法和模型。③ 抗过拟合。DenseNet具有非常好的抗过拟合性能,尤其适合于训练数据相对匮乏的应用。对于DenseNet抗过拟合的原因有一个比较直观的解释:神经网络每一层提取的特征都相当于对输入数据的一个非线性变换,而随着深度的增加,变换的复杂度也逐渐增加(更多非线性函数的复合)。相比于一般神经网络的分类器直接依赖于网络最后一层(复杂度最高)的特征,DenseNet 可以综合利用浅层复杂度低的特征,因而更容易得到一个光滑的具有更好泛化性能的决策函数。实际上,DenseNet的泛化性能优于其他网络是可以从理论上证明的:2017年的一篇几乎与DenseNet同期发布在 arXiv 上的论文(AdaNet:Adaptive Structural Learning of Artificial Neural Networks)所得出的结论表明类似于DenseNet的网络结构具有更小的泛化误差界。④ 泛化性能更强。如果没有data augmention,CIFAR-100下,ResNet表现下降很多,DenseNet下降不多,说明DenseNet泛化性能更强。

GoogleNet网络架构的主要特点:① 提升了对网络内部计算资源的利用。② 增加了网络的深度和宽度,网络深度达到22层(不包括池化层和输入层),但没有增加计算代价。③ 参数比2012年冠军队的网络少了12倍,但是更加准确。

Inception_v3网络结构在图像分类任务中,显著特征的像素上的大小显然会是不固定的。因此,去决定使用一个较大的kernel或是较小的kernel会比较难以决定。较大的kernel能关注到更global的特征,相应的较小的kernel则可以关注到具体区域内的特征。为了能识别到可大可小的特征,我们需要不同大小的内核,Inception网络就是解决这样的问题的。它并不是简单的go deeper的网络,而是go wider。它做到了在同一层中使用到不同大小的核。Inception的可以训练找到最佳的最适合的网络。每一个模块可以在不同层级捕捉显著特征。全局特征往往可以在5*5的卷积层中找到,而分布式特征容易在3*3的卷积层捕捉到。池化层可以负责捕捉low-level特征。每一个层级的特征都可以被提取出来并且链接输送给下一层训练。让网络训练去决定哪些特征获得较高的权重。比如说,如果数据集中的图像具有丰富的全局特征,而没有太多低级特征,那么训练后的Inception网络与5*5 conv核相比,对应3*3 conv核的权重会非常小。(https://www.daowen.com)

SqueezeNet是Han等提出的一种轻量且高效的CNN模型,它参数数量是AlexNet的1/50,但模型性能(Accuracy)与AlexNet接近。在可接受的性能下,小模型相比大模型,具有很多优势:① 更高效的分布式训练,小模型参数小,网络通信量减少。② 便于模型更新,模型小,客户端程序容易更新。③ 利于部署在特定硬件如FPGA,因为其内存受限。因此研究小模型是很有现实意义的。

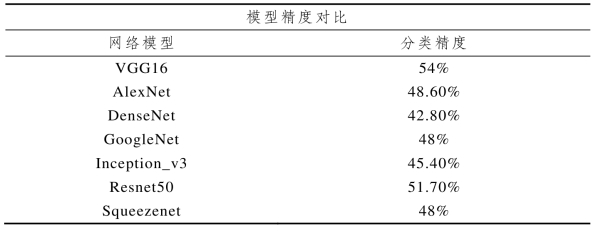

通过不同模型进行分类对比精度发现,VGG16和ResNet50两种网络模型精度较高,所以选择这两个模型进行调整,建立青花瓷年代判别模型(表3.2)。本研究采用深度学习学习技术对历代景德镇青花瓷进行年代分类,其关键是建立不同年代景德镇青花瓷分类模型,分别使用VGG16和ResNet50两种经典网络模型,对网络模型进行修改再进行不同年代景德镇青花瓷真彩色图像分类,通过VGG16和ResNet50网络模型在本研究图像分类任务上的比较,分析两者的分类效果。下面将对不同年代景德镇青花瓷分类模型的建立进行研究。

表3.2 不同模型进度对比