2.2 跨媒体社交网络内容数据获取与预处理

依据网络爬虫理论对社交网络平台的跨媒体数据信息进行获取,本节以新浪微博作为社交网络数据来源和具体实例展开。首先,构建了用户—智能体(User-Agent,UA)代理资源池。在用户—智能体资源池中建立进行代理访问的虚拟身份,在新浪微博提供的可靠权限下进行身份确认。然后,确立了目标话题内容资源选定方案和资源筛选方案。以新浪微博为代表的社交网络平台以用户为核心,因此在当前步骤下以用户节点为切入,由点及面地进行了资源覆盖并实施了可靠的可迭代递归方案以确保资源覆盖的广泛性和深入性。除此之外,建立了针对资源获取前的初步筛选判断,对新浪微博中具有特殊影响力的“大V”用户、“僵尸用户”和进行恶俗营销用户等相关信息资源进行筛选过滤。最后在新浪微博官方提供的用户接口上建立了面向目标安全话题跨媒体数据资源进行实质获取。跨媒体数据信息获取分为两个阶段。

第1阶段为跨媒体数据信息获取阶段,对跨媒体内容信息、时间信息、位置信息、用户信息、转发信息和评论信息以及其他统计信息进行获取。接着对所获取的信息进行初步格式化处理:对内容信息中的特殊表情符号进行文本化转化,对特殊标记符号进行过滤等;对时间信息进行统一格式优化;对位置信息进行精确化处理,其中包括用户使用移动互联网设备的签到信息以及用户主动提交的位置信息,还对空缺信息进行缺省化处理;对转发信息和评论信息分别进行原始内容整合,识别转发和评论过程中涉及的用户节点关联,存储到用户信息中。针对所获得信息按字段分布进行了对象简谱格式(JavaScript Object Notation,JSON)化处理与保存。

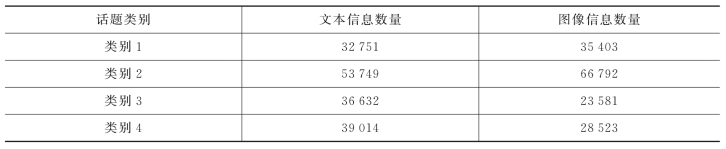

第2阶段为扩展信息获取阶段,针对所获取的内容信息区分为文本数据信息内容和图像内容链接,对图像链接所指向的图像内容进行直接获取。针对4个大类的社交网络话题信息进行了数据获取,时间跨度为2009年9月2日至2016年9月7日,获取的信息统计如表2-1所示。

表2-1 社交网络话题跨媒体内容信息获取统计

我们针对所获取的社交网络安全话题跨媒体数据进行了可计算化处理,即构造了用于大规模计算的高维向量特征表示。针对对象简谱格式化所保存的社交网络文本内容数据信息进行了分词、去停用词、去无实意虚词和去低频词及高频词等自然语言预处理操作,对所得到的有用信息进行了词嵌入映射,并定义一条微博文本信息在经过自然语言预处理后为有用词的集合,则一条微博的嵌入表示为所包含有用词相应嵌入表示的有序集合,即得到了微博文本高维向量表示。对社交网络图像内容数据信息进行了基于VGG-16网络的特征提取,在此过程中以话题语义作为标签构成了面向安全话题的跨媒体社交网络内容特征表示,为进一步跨媒体语义关联和面向内容信息处理的特征搜索提供计算处理。