5.3.1 实验设置

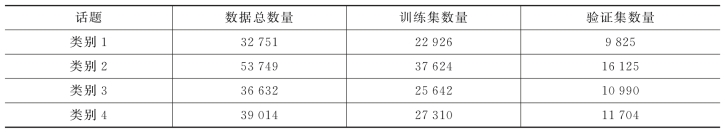

实验部分采用新浪微博作为社交网络实例,并使用在新浪微博中爬取的数据作为验证基于强化学习的社交网络话题内容匹配算法(MDPMS)数据集,如表5-2所示。

结合每条新浪微博内容的点击标记进行有监督学习训练,并通过手工的方式对点击标签创建了话题子标签,以进一步提高评估的准确性,使用NDCG和MAP进行进一步评估。基于强化学习的社交网络话题内容匹配算法(MDPMS)归类为策略无关(Off-Policy)强化学习算法的大类。

表5-2 基于强化学习的社交网络话题内容匹配算法算法数据信息描述

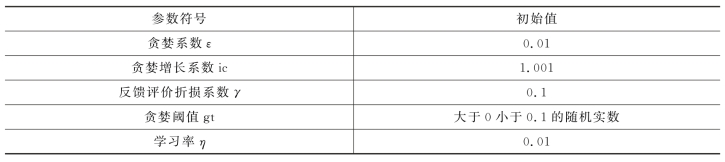

如表5-3所示,通过贪婪系数ε调节基于强化学习的社交网络话题内容匹配算法(MDPMS)对新浪微博内容选取的贪婪策略,即根据已知经验选择新浪微博内容是否作为相应位置的搜索结果。初始化时,算法没有相关经验可以依据,则通过随机选取相应的动作作用于新浪微博内容。从第二次进行动作选择时,算法以贪婪系数ε的概率对下一个时间步骤相对应的新浪微博内容进行动作选择,且选择与上一个时间步骤相同的动作。

表5-3 基于强化学习的社交网络话题内容匹配算法参数初始化赋值

基于强化学习的社交网络话题内容匹配算法(MDPMS)通过贪婪机制学习如何针对不同的新浪微博内容选择合适的动作,随着时间步骤的推移算法可以根据新浪微博内容特征选择适当的动作来选择合适的新浪微博内容以获得更高的反馈评价分数。这样的过程使得算法变得“贪婪”,不再尝试新的动作选择。算法“贪婪”的程度由贪婪增量系数控制逐渐递增。贪婪系数在每个时间步骤都会更新,随着时间步骤每向前推移一步贪婪系数更新为ε=ε×ic。贪婪系数的数学本质为浮点型实数,且取值范围为0.01<ε<0.9。

在选择新内容后将其放置在结果列表中时,算法对新的搜索状态进行评价。不断变化的反馈评价使算法能够做出符合反馈评价结果的动作选项,来选择正确的内容作为搜索结果。基于强化学习的社交网络话题内容匹配算法(MDPMS)在贪婪策略控制下达到最终状态时能够区分社交网络内容特征,即面对具体社交网络内容特征时能够明确是否将其选为搜索结果。在最终状态下,算法面对相似的内容特征时,仍有10%的概率尝试经验以外的另一个动作选项以探索更高的反馈评价。这样的设计这反映了一个事实,即其算法训练初期的经验更有价值。因此,通过反馈评价折损系数γ对累加的反馈评价进行折扣以平衡最终反馈评价。贪婪阈值gt设置了算法是否按照经验进行动作选择的开关,当贪婪系数ε大于贪婪阈值gt时,按照经验进行动作选择。

基于强化学习的社交网络话题内容匹配算法(MDPMS)在强化学习框架下以获得更高的反馈评价进行训练,并根据动作值和反馈评价进行动态社交网络内容相关性评价参数更新而实现了算法强化。在训练阶段,反馈评价是来自所有不同阶段结果的反馈,算法将从这些反馈评价中调整各种微博内容的动作选择策略,以获得更好的最终反馈评价。在每个时间步骤中,会针对特定的社交网络内容生成一个动作值来指导内容选择,并获得较高的反馈评价。当最终搜索结果构造完成时,算法对每个时间步骤产生反馈评价基于反馈评价折损系数加权求和。