5.3.2 基于强化学习的社交网络话题内容匹配算法有效性分析

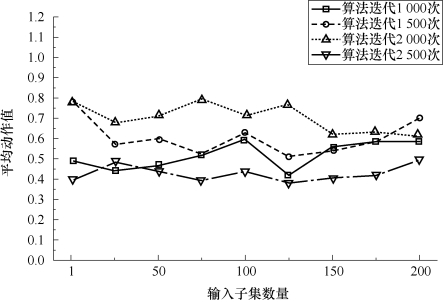

我们针对基于强化学习的社交网络话题内容匹配算法(MDPMS)训练过程中的参数变化进行了实验和评价,以保证在搜索实验中的有效性。动作定义为“选择”和“跳过”来决定不同搜索状态下的社交网络内容是否作为相应位置上的搜索结果。在强化学习框架下进行有效的动作选择是基于强化学习的社交网络话题内容匹配算法(MDPMS)训练的目标也是该算法有效进行社交网络搜索应用的必要条件。分别将“选择”和“跳过”两个动作定义为数值1和-1。为了使得算法定义的动作值更加直观,要对200个子集进行编号并逐一序列化输入到算法并将动作值求均值,不同训练阶段的平均动作值结果如图5-3所示。

实验选取了基于强化学习的社交网络话题内容匹配算法(MDPMS)在迭代训练1 000次后、1 500次后、2 000次后和2 500次后的4个阶段的算法模型对平均动作值进行了评价。随着数据子集的序列化输入,平均动作值在算法不同的训练阶段体现了不同的变化趋势。在所选用的4个训练阶段中,动作平均值均分布在正数值间,说明了算法在执行过程中面对不同的新浪微博内容做出“选择”动作的数量多于做出“跳过”动作的数量。除此之外,在算法训练过程中平均动作值在迭代1 500次后的结果分布范围高于迭代1 500次后的结果分布范围,说明算法训练从迭代1 000次到迭代1 500次的过程中,算法做出“选择”动作的数量比例有所上升。算法经过2 000迭代训练后动作值的波动范围开始下降,算法做出“选择”动作的数量比例开始下降。

这种趋势表明算法随着训练迭代次数的增加经历了探索新的动作选择经验和逐步变得贪婪而停止探索新动作选择经验过程。算法变得贪婪的事实意味着贪婪系数已退化为固定值。当算法训练迭代次数达到2 500次后平均动作值的波动中心围绕在0.4~0.55,相对于迭代1 000次、1 500次和2 000次时出现的波动异常点明显变少,可以推测在经历2 500次训练迭代后接近收敛。

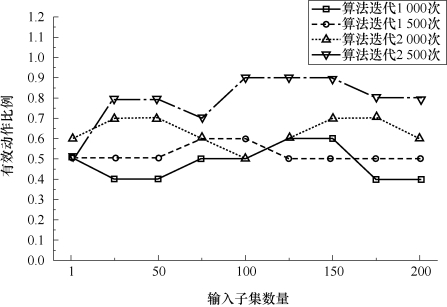

定义对与查询相关新浪微博内容做出的“选择”动作和对与查询不相关新浪微博内容做出的“跳过”动作成为有效动作。针对不同的新浪微博内容做出一系列的动作组成了适当的结果列表。在所有动作中有效动作数量所占比例越高,用户感知的搜索实用评价越高。在与平均动作值评价相同的过程下,对每个输入子集下算法做出的动作中有效动作所占比例进行评价,结果如图5-4所示。

随着算法训练迭代次数的增加,每个输入子集中有效动作比例值分布在0.4~0.9波动,并且有效动作比例值波动的中心存在变化。当算法迭代次数为1 000次时,有效动作比例值曲线在0.4~0.6波动。当算法迭代次数上升至1 500次后,有效动作比例值曲线波动范围为0.5~0.7,在整个训练过程中有效动作比例的平均值提升了约10个百分点。当算法迭代次数上升至2 500次后,有效动作比例值波动范围上升至0.5~0.9。从数值分布上看有了明显提升,说明基于强化学习的社交网络话题内容匹配算法(MDPMS)在动态社交网络内容相关性评价中所选取的内容随着算法迭代次数的增加逐渐符合目标内容。

图5-3 基于强化学习的社交网络话题内容匹配算法平均动作值评价

随着有效动作比例值趋于稳定并有所增长,MDPMS算法从2 000次训练迭代至2 500次训练迭代中,平均动作值有所下降,说明算法做出更多“跳过”的动作来处理相应的新浪微博内容。这种情况表明基于强化学习的社交网络话题内容匹配算法(MDPMS)正在逐渐更新运算参数并接近理想的数值,可以为相应的内容选择合适的动作。基于强化学习的社交网络话题内容匹配算法(MDPMS)进行了有效的训练过程,使得该算法对目标内容的语义特征逐渐具有敏感性。

图5-4 基于强化学习的社交网络话题内容匹配算法有效动作比例

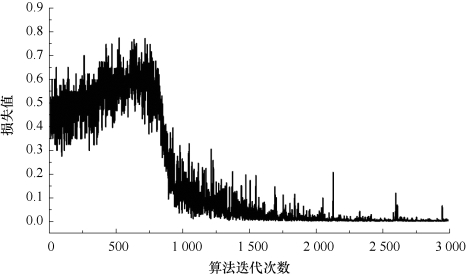

我们计算了基于强化学习的社交网络话题内容匹配算法(MDPMS)的损失函数值,并通过该算法的损失变化来进一步分析算法训练的有效性,如图5-5所示。在基于强化学习的社交网络话题内容匹配算法(MDPMS)通过贪婪系数控制等参数控制着对动态社交网络内容相关性评价中的运算参数进行优化,从而针对不同的新浪微博内容作出合适的动作并构造符合查询和用户感知效用的搜索结果列表。基于强化学习的社交网络话题内容匹配算法(MDPMS)算法损失值曲线显示了在不同训练阶段算法目标值变化趋势,也是对算法训练过程效果的直观反映。该算法约经过700次训练迭代后损失值开始降低,并在经过约2 500次训练迭代后损失值开始收敛。另外,算法在1 000次训练迭代之前损失值有所增加,这种现象与图5-3中的情况相对应,说明了算法在前1 000次训练迭代处于经验探索阶段,之后算法随着贪婪系数的增长逐渐变得贪婪并收敛。

图5-5 基于强化学习的社交网络话题内容匹配算法损失值变化