5.2.3 基于强化学习的社交网络话题内容匹配算法设计

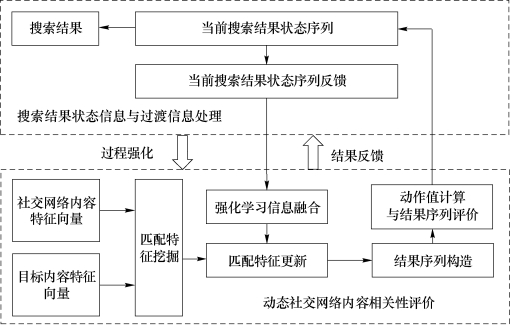

采用策略无关强化学习思路我们提出了基于强化学习的社交网络话题内容匹配算法(MDPMS),用于进行社交网络内容信息匹配与搜索,算法框架图如图5-1所示。

图5-1 基于强化学习的社交网络话题内容匹配算法框架图

由于区别于传统媒体内容的复杂社交网络内容数据特性,因此本算法采用了面向内容局部特征运算的深度学习计算算法对社交网络内容的特征向量和目标内容的特征向量进行挖掘处理。随着搜索状态的不断更新,动态社交网络内容相关性评价将搜索状态更新与过渡中的强化学习信息进行融合,对挖掘的匹配特征进行更新并构造符合要求的匹配结果序列。通过动态社交网络内容相关性评价所构造的匹配结果序列进行测评,获取当前社交网络内容与目标内容的相关性,同时作为强化学习动作选择的依据反馈给搜索结果状态,进行搜索结果状态的过渡。

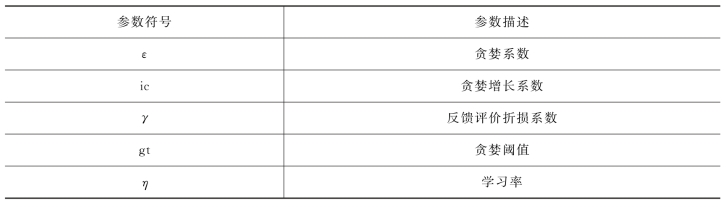

动态社交网络内容相关性评价的一个作用是,构造相对于人工特征更有效的深度特征,并直接对高维社交网络内容语义特征进行特征挖掘,形成深度学习特征表示。在策略无关(Off-Policy)的思想下,基于强化学习的社交网络话题内容匹配算法(MDPMS)通过动态社交网络内容相关性评价在反复搜索经验演练的基础上运行。这个过程在有监督学习下与点击标记(Click-Through)数据进行交互,数据形式定义为{<d 1,L 1>,<d 2,L 2>,…,<d l,L l>},其中l是社交网络内容列表的长度。根据强化学习的定义,MDPMS算法中涉及的参数符号和含义如表5-1所示。

表5-1 基于强化学习的社交网络话题内容匹配算法的部分参数与描述

贪婪系数ε和贪婪增长系数ic是保证强化学习贪婪策略的参数,贪婪策略即使目标函数取值持续保持最大的策略,通过控制贪婪系数和贪婪增长系数来实现;反馈评价折损系数γ,是未来的经验对当前状态执行动作选择来说重要程度的衰减系数,即随着算法进行,动作选择经验使得算法确定在什么情况下做出什么样的动作选择会使得目标函数取值最大,从而逐渐忽略算法经验;贪婪阈值gt,当贪婪系统数增长超过贪婪阈值后,算法的贪婪程度不在增加,即贪婪系数不在变大;学习率η,为机器学习概念范围内的算法参数学习率。在此基础上,基于强化学习的社交网络话题内容匹配算法(MDPMS)描述如下所示。

每一个时间步骤下做出的动作计算瞬时反馈是下一个时间步骤进行动态社交网络内容相关性评价中运算参数更新的关键,即是相邻的时间步骤间实现搜索结果选择强化的关键,是通过更新算法定义中的状态、观测、过渡和反馈评价等信息对动态社交网络内容相关性评价进行过程强化的实际过程。动态社交网络内容相关性评价的直接目的是针对当前时间步骤下面对的社交网络内容特征向量做出动作,即“选择”或“跳过”这个内容作为搜索结果内容的一部分。动态社交网络内容相关性评价针对当前时间步骤下面对的社交网络内容特征向量做出的所有动作,直接构成了最终的搜索结果序列。

算法5-1 基于强化学习的社交网络话题内容匹配算法

输入:用于训练的社交网络内容特征向量集合和目标内容特征向量集合等待处理的社交网络内容特征向量集合和目标内容特征向量集合

输出:搜索结果列表

(1)载入用于训练的社交网络内容特征向量集合和目标内容特征向量集合

(2)初始化如表5-1中所提到的超参数

(3)初始化动态社交网络内容相关性评价参数矩阵

(4)初始化算法定义中的状态、观测、过渡和反馈评价等信息

(5)对于每一个时间步骤,若贪婪系数小于贪婪阈值,则进行步骤5,否则进行步骤6

(6)随机选择一个当前内容来决定是否将内容作为搜索结果

(7)依据动态社交网络内容相关性评价生成动作值来决定是否将内容作为搜索结果

(8)根据步骤6或步骤7选择的搜索结果计算瞬时反馈

(9)更新贪婪阈值

(10)依据步骤6或步骤7更新搜索结果序列

(11)更新算法定义中的状态、观测、过渡和反馈评价等信息

(12)计算当前时间步骤所做出的动作计算瞬时反馈评价

(13)依据瞬时反馈评价进行动态社交网络内容相关性评价中运算参数的更新

(14)进行下一个时间步骤,执行步骤4

(15)重复步骤4至步骤12,直至动态社交网络内容相关性评价中运算参数收敛并保存参数

(16)载入等待处理的社交网络内容特征向量集合和目标内容特征向量集合

(17)应用已经收敛的运算参数,对等待处理的社交网络内容特征向量集合进行动态社交网络内容相关性评价

(18)依据动态社交网络内容相关性评价结果动态构造搜索结果列表

(19)返回搜索结果列表

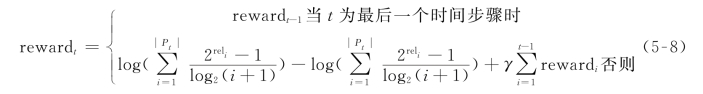

计算的瞬时反馈评价关系到当前时间步骤下面对的社交网络内容的动作选择,因此,每个时间步骤下搜索结果列表会根据社交网络内容的动作选择而重建。当进行到时间步骤t时,瞬时反馈评价计算方式如式(5-8)所示。

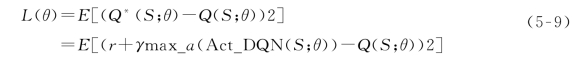

若当前时间步骤为最后一个时间步骤时,瞬时反馈为上一个时间步骤的反馈评价。否则,将当前时间步骤的reward〔计算如式(5-8)所示〕与前面所有时间步骤的反馈评价加权求和作为最终反馈评价。当算法收敛时算法迭代结束,得到优化后的动态社交网络内容相关性评价,所产生的动作选择值是对社交网络内容特征向量与目标内容特征向量的语义特征运算得到,并且串联了基于强化学习的社交网络话题内容匹配算法(MDPMS)定义中的关键概念。该算法的目标是学习和优化动态社交网络内容相关性评价中的运算参数,以生成合适的动作值作为用户感知的评价来选择或跳过不同的社交网络内容,并构造最终搜索结果列表。为了进行算法学习和优化,算法5-1中采用均方误差作为损失函数,损失函数如式(5-9)所示:

其中,损失函数的学习目标是使通过rt+γr_NDCG(Pt⊕Pt+1)计算得到的目标值Q*(S;θ)接近真实值。通过均方误差损失函数对目标值和真实值之间偏差的数学期望进行计算。损失函数中γ是控制目标值变化的反馈评价折损系数。Q(S;θ)为对应的真实值,通过目标值与真实值的均方误差计算来用作动作值的计算评价。动态社交网络内容相关性评价通过生成动作值来选择或者跳过内容作为搜索结果列表的一部分,针对不同社交网络内容生成不同动作值作为用户感知的数值依据。动态社交网络内容相关性评价作为关键功能是分析不同社交内容的语义特征,并结合目标内容特征向量计算当前社交网络内容的动作值并构造搜索结果序列。