9.1.3 数据模型

为了明确捕捉可能影响企业效率的重要因素,并帮助企业领导者选择更好的长期发展策略,本书采用了许多不同的机器学习模型,如决策树、随机森林、神经网络、XGBoost等。本章主要介绍了这些模型的基本原理。

(1)决策树模型

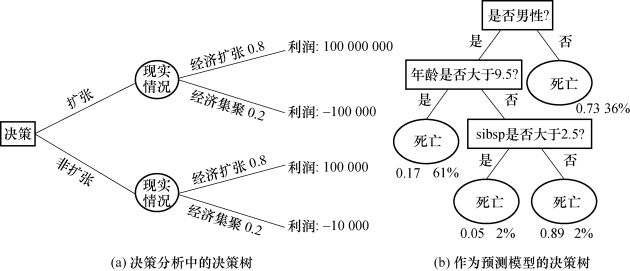

决策树有两种类型。一种类型的决策树常用于决策分析,其结构类似于流程图且包含着决策过程和结果。如图9.2(a)所示,这种类型的决策树由三种节点组成:决策节点、机会节点和终节点。另一种类型的决策树被用作机器学习的预测模型,如图9.2(b)所示,它基于若干输入变量来预测目标变量的值。本部分重点介绍后者,称其为决策树学习。

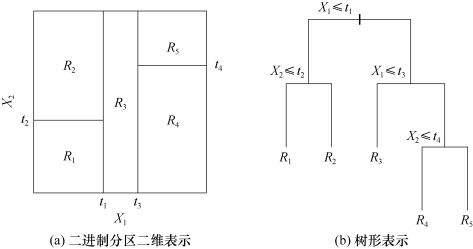

树状模型方法将特征空间划分为一组矩形,然后在每个矩形中嵌入一个简单的模型(如一个常量)。为了简化问题,本书将注意力集中在如图9.3(a)所示的递归二进制分区上。首先把这个空间分成两个区域,然后用每个区域的平均值来模拟响应。本书选择变量和分割点来达到最佳匹配,然后将这些区域中的一个或两个区域划分成更多的区域,并依此类推,直到满足停止规则为止。图9.3(b)中的二叉树可以表示这一相同模型,递归二叉树的一个关键优点就是可解释性,一棵树便能完全描述特征空间的分区情况。

图9.2 决策树模型

图9.3 决策树决策过程示意图

机器学习中的决策树可被分为两类——回归树和分类树。以上两类之间唯一的区别在于划分节点和剪枝的标准不同。回归树采用平方误差和节点不纯度的测量方法,但不适合分类。因此对分类树会采用不同的测量方法,如误分率、基尼指数和交叉熵。

(2)随机森林

装袋法(bagging)或自举汇聚法(bootstrap aggregation)是一种对估计的预测函数进行缩减方差的方法。随机森林算法是对装袋法的实质性改进,算法中建造了大量的去相关树,然后求出它们的平均值。随机森林算法的性能在很多情况下均与Boosting算法十分相似,且它的训练和调整策略也更为简单。因此,随机森林算法更受欢迎。

像决策树模型一样,随机森林算法也可以用于回归和分类。当用于分类时,随机森林算法是从每棵树上获得一个分类表决,然后根据多数投票进行分类。当用于回归时,模型将简单地计算出目标点x处的每棵树预测值的平均值。

(3)神经网络

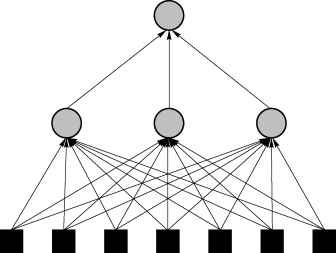

神经网络是一种基于人脑特征的计算模型。它良好的适应性、自组织性和自学习能力使其成为数据分类和模式识别的有力工具。它的中心思想是提取出输入的线性组合,并将其作为派生特征,然后将目标建模成为这些特征的非线性函数。图9.4显示了一个单隐层神经网络的结构。

图9.4 单隐层神经网络示意图

反向传播算法是最常见的神经网络训练算法,它通过计算每个神经元的误差组成来更新模型的权值。正如本部分中所阐明的那样,它们是非线性统计模型。