实验设计与结果分析

(一)实验数据集

本文使用的数据集来自EyePACS公开数据集中的眼底图像。该数据集最初用于进行DR的分级诊断,2017年新加坡A*STAR(Agency for Science Technology and Research)组织对该数据集进行图像质量的标注。包括眼科专家在内的专业人士根据能否通过图像进行眼疾病诊断来进行质量标注。每张图片由至少三个人进行判断,根据少数服从多数原则来确定图像质量的标签。其中标签1表示质量良好的图像,代表其在医学上可以用于后续的诊断分析;标签0表示具有相反属性的低质量图像。从数据集中随机选取3 864个原始样本作为训练集,随机选取1 200个原始样本作为测试集。其中训练集中包含2 092个标签为1的样本和1 772个标签为0的样本,测试集中包含582个标签为1的样本和618个标签为0的样本。

(二)评价指标

为了验证所提出的方法在眼底图像质量评估上的性能,实验使用分类准确率(accuracy,ACC)、特异性(specificity,SPE)、敏感性(sensitivity,SEN)和ROC曲线下方面积(the area under ROC curve,AUC)的值作为分类性能的度量来量化结果。分类准确度度量的是预测真实类标签的有效性,表示正确预测的样本个数占总样本的比例。特异性表示图像质量好的、可接受眼底图像被正确分类的比例,敏感性表示图像质量差的、不可接受眼底图像被正确分类的比例。AUC值度量的是在二分类情况下,当随机取一个样本时,决策函数分配给正样本的得分高于负样本的概率,通常AUC值表示ROC曲线下的面积。

(三)实验结果与分析

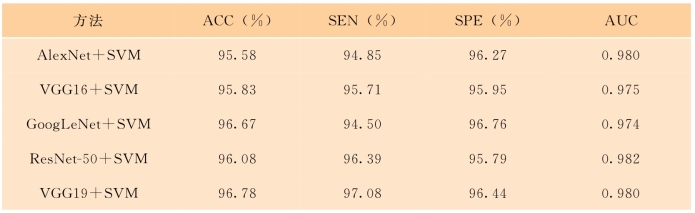

将提出的算法与一些其他算法进行比较,分类结果如表4-1、表4-2所示。在实验中,首先比较了本算法采用的卷积神经网络VGG19网络与当前典型的CNN在眼底图像质量评估上的分类性能。采用基于迁移学习原理微调CNN的方法,提取卷积神经网络的全连接层特征并训练SVM分类器,从表4-1中可以看出,使用迁移学习原理微调CNN均获得了较好的性能,这表明从自然图像学习到的知识可以迁移到医学图像上,从而有效地进行医学图像质量分类。同时VGG19网络在眼底图像质量分类表现度量上与其他CNN相比具有更好的结果,VGG19网络获得了96.78%的准确率、97.08%的敏感性、96.44%的特异性以及0.980的AUC值。本算法将采用VGG19网络学习的特征与显著性特征进行特征融合。

表4-1 不同CNN在眼底图像质量评估上的分类结果

本算法分类结果如表4-2所示。在实验中,提取VGG19网络的全连接层特征并组成一个4 096维的特征向量,接下来提取显著图特征(1 024维特征向量),并将这两种特征分别归一化后进行连接,融合这两种特征成一个融合的特征向量,最后送入SVM进行分类。从表4-2可以看出,将显著性特征和卷积神经网络学习的特征融合的方法在分类表现度量上均获得了最好的结果,本算法获得了97.24%的准确率、97.08%的敏感性、97.25%的特异性以及0.993的AUC值,与单独使用CNN特征或单独使用显著图特征进行眼底图像质量分类相比有明显的提高。为了进一步地展示所提出方法的有效性,图4-8给出了不同方法的ROC曲线,通过图4-8可以看出,我们提出的算法在ROC表现上依旧取得了最好的结果。(https://www.daowen.com)

表4-2 所提算法在眼底图像质量评估上的分类结果

图4-8 眼底图像质量分类任务ROC曲线图

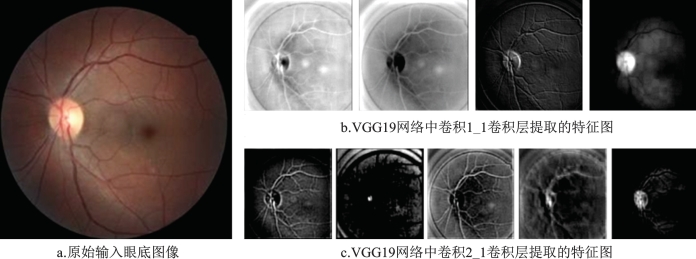

在深度卷积神经网络中,CNN作为特征提取器可以提取诸如边缘和局部对比度之类的简单特征并且可以从这些低层特征中学习到复杂的高层特征。为了展示卷积神经网络学习的信息,我们给出了VGG19网络中两个卷积层提取的一些特征图,如图4-9所示。图4-9a为输入网络的彩色眼底图像,图4-9b为VGG19网络中conv1_1卷积层提取的部分特征图,图4-9c为VGG19网络中conv2_1卷积层提取的部分特征图。可以看出,网络学习提取了眼底图像的几何信息如血管结构的边缘及视盘等相关的结构信息,并且网络逐层抽象更高的特征。

传统的基于手工特征的眼底图像质量评估方法已经被广泛应用于眼疾病自动诊断筛查系统中。但是,传统方法基于通用图像质量参数或结构图像质量参数,需要设计特定的手工特征,算法复杂度比较高,在新的数据集上泛化能力差,无法应用在较大的数据集上。鉴于此,提出了一种基于人类视觉系统的眼底图像质量评估方法,该方法利用人类视觉系统的处理信息方式,将基于卷积神经网络的监督信息和基于显著图的无监督信息结合,进而构建分类器并进行眼底图像质量分类。在深度网络的学习中,使用迁移学习原理微调卷积神经网络的方法来提高分类性能。在较大的眼底图像数据集上的实验结果也验证了本算法的优越性,本算法在分类表现上具有最好的性能。

图4-9 原始输入眼底图像及对应的两个卷积层提取的特征图