基于人工智能的视盘定位方法实例

(一)基于深度卷积神经网络的眼底图像视盘定位方法流程

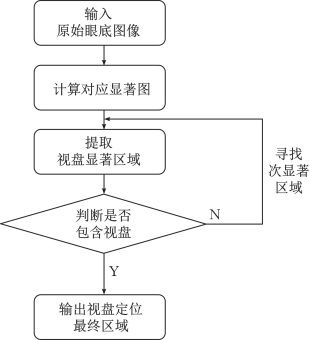

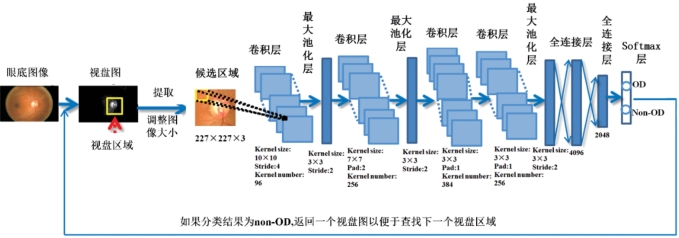

基于深度卷积神经网络的层级式视盘自动定位方法的具体流程,如图6-16所示,主要分为两个部分:候选区域提取和视盘区域判断。首先在眼底图像对应的显著图上根据亮度特性提取视盘显著区域,然后将提取的区域输入深度卷积神经网络中进行判断,若深度卷积神经网络判断为非视盘区域,则返回显著图,寻找次显著区域并输入深度卷积神经网络中进行判断,重复以上过程直到判断为视盘区域,最后输出深度卷积神经网络判断为视盘的区域,将其作为视盘定位的最终结果。

图6-16 基于深度卷积神经网络的层级式视盘自动定位方法流程图

(二)显著图及候选区域提取

由于用一个滑动窗口扫描整幅眼底图像,再依次判断是否包含视盘区域,最终定位所需的时间较长,而且定位每幅图像的计算量相对较大,因此为了达到快速检测视盘的目的,本实例对眼底图像进行处理以得到相应的显著图,在显著图的基础上根据亮度特性定位视盘显著区域,并从原彩色眼底图像中提取出相应的区域,输入深度卷积神经网络中进行下一步的判断。

视觉显著是一种感知质量,它使图像中的物体、人物、像素等相对于周边区域更加突出,从而吸引人们的注意。目前,视觉显著图像区域检测被广泛应用于物体分割、自适应压缩和物体识别领域。

视觉注意来源于自下而上的快速前注意视网膜输入的视觉显著或自上而下的缓慢的基于任务的记忆和意识处理。本实例采用频率调节显著区域检测方法,该方法是一种基于中心周边对比性的低层、前注意显著区域提取方法,可以自动检测图像中的视觉显著区域,在图像分割和物体识别任务中效果显著。通过保留原始图像中更多的频率内容,保持了物体的边缘细节,使得该方法计算的显著图中显著物体边缘清晰。基于频率调节的显著图计算方法有效利用了图像中的色彩和亮度低层特征,实现过程简单且可以产生全分辨率的高清显著图。

该方法首先对原始图像使用高斯滤波器以消除噪声和纹理细节,之后对图像的LAB色彩空间上的各个分量进行归一化操作并计算每个像素对应的L2范数,假设S为图像I对应的显著图像,则具体的计算公式如下:

![]()

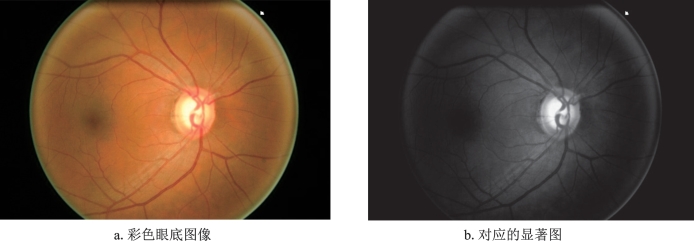

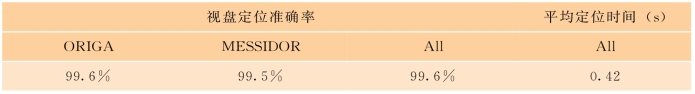

其中Iμ为图像的像素算术平均值,Iwhc(x,y)代表高斯模糊后图像对应的像素向量值,![]() 为L2范数。在LAB色彩空间中,每个像素是一个[L,a,b]T向量,L2范数代表欧式距离。图6-17展示了眼底图像对应的显著图。

为L2范数。在LAB色彩空间中,每个像素是一个[L,a,b]T向量,L2范数代表欧式距离。图6-17展示了眼底图像对应的显著图。

图6-17 眼底图像对应的显著图

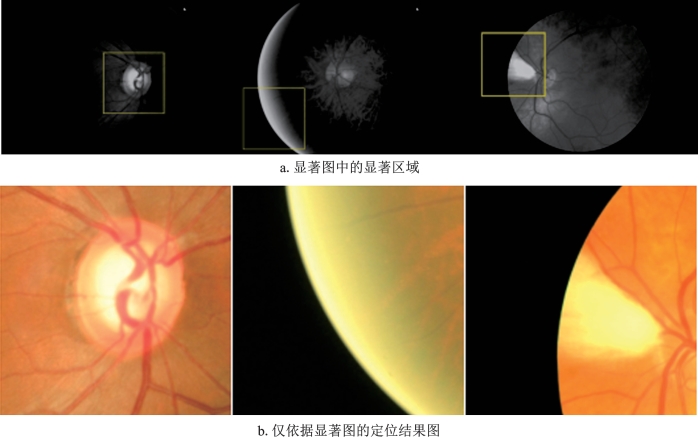

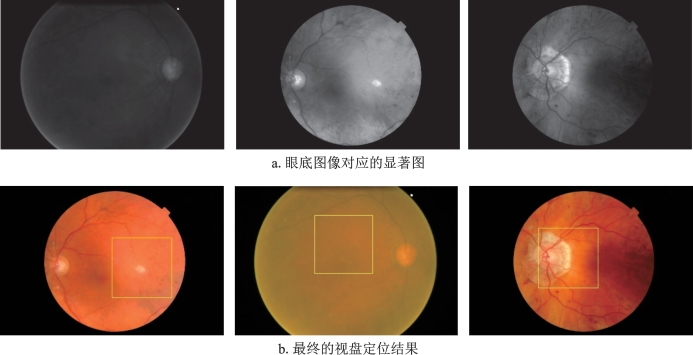

显著图是根据人类的视觉特性(如高对比性)将物体高亮从而显著于周边区域,在理想情况下,可以将显著图中定位的高亮度区域作为视盘区域。但当图像中出现干扰项时,如拍摄位置不正导致的视网膜亮边缘或病理变化导致的亮损伤,仅利用显著图会错误地定位视盘的位置。仅依据显著图定位视盘的结果,如图6-18所示。因此,本实例采用基于深度卷积神经网络的方法判断根据显著图提取的候选区域是否包含视盘。

(三)候选区视盘分类深度卷积神经网络

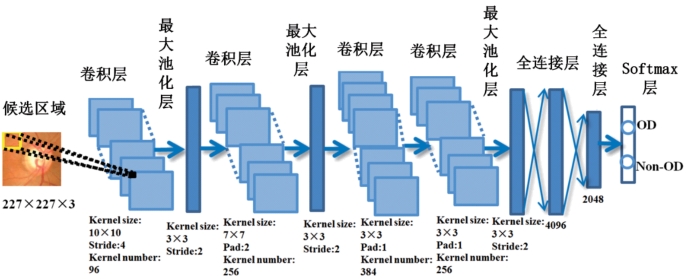

在显著图的基础上提取视盘候选区域后,本实例采用了一种基于深度卷积神经网络的判断方法,且受到Alex Net网络结构的启发,设计出一种精简的便于训练的深度卷积神经网络。该网络主要有7层:4层卷积层、2层全连接层和1层Softmax分类层,可以较好地学习眼底图像中的视盘特征,参数相对较少因而便于训练。候选区视盘分类深度卷积神经网络的具体结构,如图6-19所示。

图6-18 仅依据显著图的视盘定位结果图

图6-19 候选区视盘分类深度卷积神经网络结构图(https://www.daowen.com)

为了更好地拟合视盘的非线性特征,该网络在每个卷积层和全连接层后都采用了Re LU非线性激活函数。并且出于网络模型泛化性能的考虑,在前两个最大值池化层后添加局部响应归一化操作的同时在全连接层采用Dropout方法防止过拟合的发生。网络的损失函数采用交叉熵损失函数。最后对全连接层的2 048个抽象特征值采用Softmax函数得出一个概率向量,依据概率值的大小进行候选区域的视盘分类,根据分类结果决定是否输出最终的视盘定位结果。基于深度卷积神经网络的层级式视盘自动定位方法的整体结构,如图6-20所示。

图6-20 基于深度卷积神经网络的层级式视盘自动定位方法的整体结构图

由于仅根据显著图定位视盘时错误区域大多在视网膜的亮边缘和亮损伤区域,这些区域基本不包含任何视盘部分,同时考虑到该深度卷积神经网络在区分包含大部分视盘和完全包含视盘区域上困难程度较高。因而在训练深度卷积神经网络时,采用一个滑动窗口,在眼底图像上选择完全包含视盘和完全不包含视盘的区域块组成训练图像集与测试图像集,从而使深度卷积神经网络更好地学习视盘的特征和视盘区域与非视盘区域的差别。

(四)数据集

本实例在ORIGA数据集和MESSIDOR数据集上训练和评估基于深度卷积神经网络的层级式视盘自动定位方法。ORIGA数据集是一个青光眼眼底图像数据集,总共有650张不同对象的左右眼图像,其中被诊断为青光眼的眼底图像有168张,正常人眼底图像482张。每张图像均由高分辨率视网膜眼底照相机拍摄,被保存为3 072×2 048的高清数字图像,同时由专业医生标注了视盘与视杯的边界和最终的诊断结果。MESSIDOR数据集是一个公开的糖尿病视网膜病变眼底图像数据集,总共包含1 200张彩色数字眼底图像,分别来自3个眼科机构,图像采集于Topcon TRC NW6免散瞳眼底照相机,被保存为TIFF格式。数据集中的图像包含3种尺度大小:1 440×960、2 240×1 488和2 304×1 536。每幅眼底图像都有专业医生的医学诊断结果。

(五)实验设置

在本实例中训练深度卷积神经网络模型时,考虑到深度卷积神经网络参数较多,训练时取ORIGA数据集的前500张和MESSIDOR数据集的800张图片,测试时采用ORIGA数据集的后150张和MESSIDOR数据集的剩余400张图片。由于深度卷积神经网络输入的是候选的视盘区域,所以在训练图片和测试图片上使用以50像素为步长的滑动窗口得到训练和测试的区域块图片集。并且因为ORIGA和MESSIDOR数据集的图像尺寸不同,根据经验,在ORIGA和MESSIDOR上分别以800×800和400×400为窗口大小。为了降低深度卷积神经网络模型学习视盘特征的难度,选择完全包含视盘区域和完全不包含视盘区域作为训练集和测试集,并且将这两种区域分别标注为1(正样本)和0(负样本)。

由于区域块数据的正负样本数量差距较大,具体来说,在原本的训练集中有631 000张负样本和57 000张正样本。为避免样本数量差距较大导致的模型训练问题,实验中并不使用全部的负样本,而是从训练集的负样本中随机选择57 000张并使用全部的正样本,最终的训练集和测试集图片数量分别为114 000张和40 000张。考虑到计算和存储的消耗,所有的输入图像块被缩放为227×227。为了解决图像的明暗强度差异问题,对输入的图像块进行各个通道减均值的预处理操作。

在训练好视盘分类的深度卷积神经网络模型后,将显著图与深度卷积神经网络相结合构成最终的基于深度卷积神经网络的层级式视盘定位模型。由于输入的眼底图像大小不同,动态调整定位窗口的大小,在ORIGA数据集上统一采用800×800的窗口,在MESSIDOR数据集上将输入的彩色眼底图像高度的20%作为定位窗口的大小。在使用该模型进行视盘定位时,对输入图像首先计算其对应的显著图,之后用一个20×20的窗口在显著图上滑动并根据亮度大小寻找最亮的显著区域,将其作为定位框的中心。在原始彩色图像上提取出对应区域并输入深度卷积神经网络中进行判断,若判断为视盘区域,则将此区域作为最终的定位结果,否则回到显著图,寻找次显著区域继续判断。循环一直持续到深度卷积神经网络判断所提取区域为视盘或达到最大循环次数。

(六)定位结果

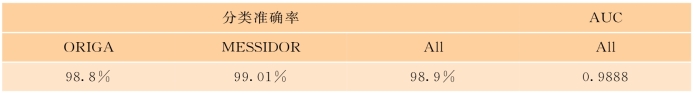

表6-6和表6-7展示了基于深度卷积神经网络的层级式视盘定位方法最终结果。表中展示了整个测试集的分类(定位)准确率、AUC值和平均定位时间,以及测试集中ORIGA数据集和MESSIDOR数据集的分类(定位)准确率。

表6-6 视盘分类准确率及ROC曲线下面积(AUC)

表6-7 视盘定位准确率和平均定位时间

图6-21展示了本实例中定位错误的结果,从中可以看出,在眼底图像整体亮度过低和出现亮损伤时,视盘定位结果会产生较大偏差,这主要是由于在训练时缺乏此类图像,以及某些亮损伤与视盘结构的高度相似性。

图6-21 错误定位结果