2.2.3 衡量人工评价结果的指标

评价的内部一致性(intra agreement)和外部一致性(inter agreement)用于衡量人工评价译文质量的信度和可靠性。内部一致性指的是同一个评分者在不同时间对于同一项评价内容评价的相关性,体现个体评价者在不同时间评价结果波动情况。外部一致性指不同评分者对同样评价内容评价结果的相关性,反映不同人在相同时间点对译文看法的差异性。

克隆巴赫系数(Cronbach Alpha),也称Alpha信度系数,是常用于考察变量之间内部一致性的统计量。Alpha系数是变量相关度的期望值,随着变量相关度的增大而增大。一般认为Alpha系数在0.9以上是信度很好,0.8-0.9之间认为较好,0.7-0.8之间认为信度可接受,0.7以下则是一致性不好或者不可接受。Alpha系数一般用来计算组内评价人员的一致性。

衡量外部一致性的指标常用Cohen的Kappa系数(Cohen,1960)或加权Kappa系数(Cohen,1968)。Kappa系数K计算方法如式2-1.

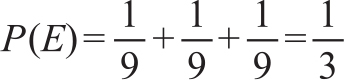

其中,P(A)为两个变量取相同值的概率,P(E)为随机条件下两个变量值相同的概率。译文质量评价中,P(A)就是两个评测者评价结果相同的次数的比例,P(E)为基于随机猜测二者评测结果相同的概率。比如,对于两个译文A和B的评测有3种结果情况(大于号表示优于,等号表示相似):

A>B,A=B,A<B

这样,评测结果相同的随机概率就是:

Kappa系数是位于0-1之间的一个数,越大说明一致性越高。根据Landis & Koch(1977)的结论,Kappa系数分为5档,K值0.2以下,几乎没有一致性,0.2-0.4之间一致性较低,0.4-0.6之间为中等程度,0.6-0.8之间为较高,0.8以上代表几乎完全一致。由于考虑了随机情况下相同的情况,因此Kappa系数比简单计算评价结果相同的比例更能科学地反映评价的一致性。

在译文评测中,研究者们也发现,评价的内部一致性一般高于外部一致性。有参考译文时,评测人员的外部一致性高于没有提供参考译文时的一致性。除了参考译文的有无可以影响评测的一致性,译文的长度等因素也会影响一致性。

由于目前机器翻译的质量仍无法替代人工翻译,机器译文的特点与语言学习者译文的特点也很不相同,产生翻译错误的类型存在很多差异,评价学生译文的标准还难以直接应用到评价机器译文中,特别是一些定性的评价标准对机器翻译系统是不适合的。一般来看,量化的评价标准更能明确翻译系统性能的变化,并利于系统的改进。评价结果的衡量指标也通常指量化的评价结果。