算法新闻伦理失范的表现

在以新闻从业人员为生产主体的新闻背景下,传播伦理的探讨主要集中于媒介审判、个人隐私与公众知情、暗访边界、灾难报道等问题上。算法媒体时代,新闻伦理问题的探讨出现了比较大的转变,由于技术背后的不透明的运作模式、智能推荐、传统把关的颠覆等问题,新闻伦理从新闻内容、新闻从业者的行为转变到了技术自身规范上来。算法技术一方面为传媒业的发展带来了机遇,另一方变也引发了算法带来的算法偏见、隐私侵犯、虚假新闻等伦理问题讨论。

(一)非法采集与隐私侵犯

算法新闻生产的基础是数据,数据是进行自动化新闻生产与个性化推荐的重要依据。然而现实环境中,有很多的数据并不属于开放数据,一些机构与科技公司为了能够获取丰富的数据,只能通过“非法采集”来获取。2012年,谷歌公司为了能够跟踪用户浏览数据,绕过“苹果”浏览器的安全设置,私自植入了用户数据包,即使在用户使用“隐身模式”时,也只能删除历史数据,而不能删除行为轨迹。实际上,美国媒体从2013年开始利用传感器采集数据,它们24小时全天候的采集用户信息,而用户自己却不自知。2018年,英国政治数据分析公司“剑桥分析”(Cambridge Analytica)被爆出在未经用户允许的情况下,用算法技术采集了5 000万“脸书”用户的信息,并将这些数据用于了政治活动中,试图控制选民的投票倾向。在我国,非法采集数据信息的事件也频频发生。2019年以来,为了打击非法采集,公安部组织展开了“净网2019”专项行动,依法查处违法违规采集个人信息的APP共683款。尽管打击力度加大,但是在算法技术推动之下,个人几乎毫无“隐私”可言,非法数据采集屡禁不止。在用户日常使用互联网的过程中,其打开某个应用或浏览某个网页,整个过程都被完全“监控”,无论用户是否选择登录,后台都可以通过算法获取并分析相关数据,这无疑是在对用户隐私进行窥探。手机暴露的用户隐私之外,传感器也无处不在获取用户隐私信息。算法媒体时代,用户时刻处于隐私暴露之下,随时面临隐私侵犯风险。近两年来,我国加大了对非法采集与侵犯隐私的产品及企业的打击力度,大量APP被勒令整改或下架处理,非法采集与侵犯隐私现象有所缓解。

图15-11 《公安机关开展APP违法采集个人信息集中整治》

(二)算法偏见与思维固化

算法偏见产生的土壤是大量的结构化数据,尽管数据是本身是客观存在的,但是数据能否准确地反映现实是有待商榷的。在此情况下,算法偏见极易产生。以抖音平台的“人脸贴纸”为例,其通过采集大量用户的五官数据,从而制作出符合“大众”的“人脸贴纸”尺寸与标准。但实际上,其所采集的数据源主要就是日常使用抖音平台进行拍摄的“主流”用户,因此所生成的“人脸贴纸”在被老年群体或幼儿群体选择使用时,常常会“失效”。算法通常只能看到用户行为本身,但是难以解读行为背后的内容,因此也极易造成偏见。例如对一条新闻进行阅读时,用户平均浏览时长为1分钟,其中有2名用户的浏览时间均为2分钟,一个用户是由于网速慢,多次刷新造成的浏览时间过长,其本身对于这条新闻内容是不感兴趣的,而另一个用户则是因为自身对于这条新闻内容非常感兴趣而花费了较多时间阅读。算法基于2名用户的浏览时长,会误判2名用户均对这一类型报道感兴趣,从而加大这类报道的推送力度,实际上,这样的推送也是带有算法偏见的。算法偏见的另一重要表现是算法设计者的偏见,算法工程师全程参与了整个算法程序的搭建,包括了学习目标设定、模型选择、特征(数据)选取等,算法工程师在进行设定时不可避免的会将自己的看法作为重要参考标准,以此将自身的“固有成见”带入到了算法之中。例如一套线上智能面试系统,相关特征包括了年龄、学历、性别……当工程师自身将性别因素放在首位作为核心考量标准时,算法在机器学习过程中会识别到工程师的想法,从而在整个面试系统搭建时,在众多特征中将性别作为核心因素。基于算法的个性化推荐的实质是建立信息过滤机制,将用户“感兴趣”的信息分发用户,用户就会收到大量的同质化的内容,从而陷入“信息孤岛”之中。用户在个性化推荐机制下容易放大对于信息的选择性注意,从而忽略了社会全景,导致“回声室效应”,使得个人思维固化。

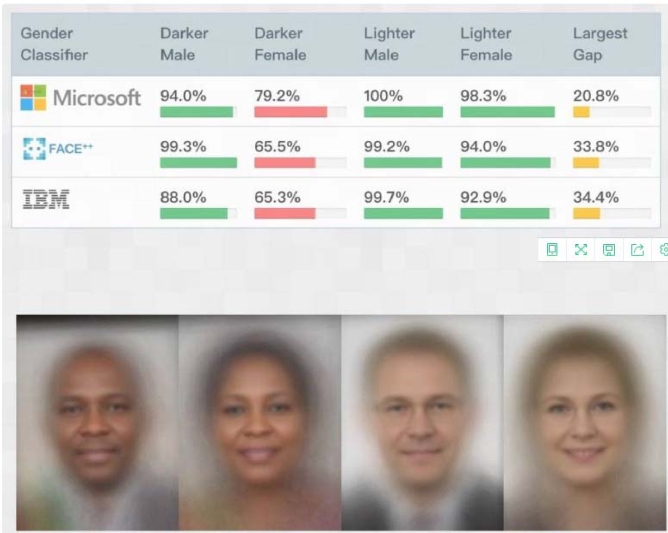

图15-12 算法偏见——微软、Face++和IBM三家的人脸识别产品,均存在对女性和深色人种“歧视”(图片来源:算法正义联盟官网)

(三)低俗内容与虚假新闻频发,人文关怀缺失

“流量为王”在现今成为了热词,平台或机构为了能够获得高点击率,赢得流量,对算法产生了较强的依赖性,通过算法进行个性化推荐迎合用户的需求,从而获取高流量。因此,大量低俗化、过度娱乐化的内容被生产与传播,用户对于这类“趣味”内容的高关注,使得严肃内容为它们让路。个性会推荐让低俗内容频繁地出现在用户推荐首页,极易造成用户“垃圾信息成瘾”。为了能够更大程度上获取用户注意力,还出现了大量的“标题党”新闻,新闻标题用词低俗,满足部分用户的猎奇心理。虚假新闻频发也是算法新闻伦理失范的重要表现,算法新闻中的虚假新闻主要包括两类,一类是数据源失实或程序设计不合理导致新闻报道失实。2019年,一则署名为“金鹰955电台”的新闻报道《一辆客车在湖南常德自燃 人员伤亡情况不明》在腾讯新闻发布,经核实,该内容并非“金鹰955电台”编辑或记者所写,而是由腾讯新闻写作机器人通过算法挖掘相关信息自动生成的。这样的失实新闻如今在算法时代频发,由于数据的量化属性和算法的权威性,其造成的失实更难以被及时察觉。另一类是利用算法进行新闻分发时未核实真相,加速虚假新闻的扩散。例如“重庆万州公交坠江”事件中,多家媒体与自媒体在未证实真相之前将事故原因归结为“女司机逆行”,此新闻被通过算法推送给了大量用户,一时间造成了巨大的传播影响,网络上充斥着这条假新闻,给女司机及其家人带来很大困扰。

算法毕竟没有生命,因此算法新闻往往缺乏新闻“三度”,即高度、深度与温度。在记者和编辑深入细致的事件调查背景下,通过多样化的写作形式,新闻报道通常是有生命力与感染力的,而算法新闻的机械化生产,使得新闻报道格式固化,表达单一,缺乏情感话语。模板化生产难以对内容进行细节化描述和深入剖析,更无法拔高到思想价值领域,从而导致新闻内容“温度”不足、缺乏人文关怀。